AI推理“最优解” | AMD EPYC你用对了吗?

打造新质生产力,将人工智能(AI)推向行业应用的纵深至关重要。而这就需要强大的算力作为支撑和保障。

术业有专攻

CPU更适合AI推理

大模型的火爆,使得人们对于AI训练倾注了极大热情,各类AI加速器,尤其是GPU成了香饽饽。殊不知,在AI生命周期中还有另外一个重要支点,那就是AI推理。比如,在银行、保险公司,信用评分、欺诈检测、风险管理等,越来越仰仗AI推理;在自动驾驶和交通运输方面,自动驾驶汽车、无人机、车辆故障预测等也要依赖于AI推理;在人们熟知的医疗保健领域,AI推理已经可以用于疾病诊断、患者监护、药物发现、医疗图像分析等。

AI训练是AI生命周期中数据和处理最密集的环节,高度计算密集型操作必然需要大规模算力作为基石。因此,大规模并行的GPU就成了AI训练的首选。再看AI推理,它是AI模型的工作阶段,即基于训练好的模型,对新数据进行分析和处理,以生成预测、分类或决策的过程。相对训练来说,推理只需较小的算力,但由于更接近数据的实际位置,所以特别看重持续运算能力与低延迟。如果说GPU是AI训练的最优解,那么从性能、能效、兼容性、性价比等方面综合考虑,CPU则是AI推理的最优解。

随着AI在各行业领域中的渗透率逐步提高,AI的实际应用,即推理的重要性正日益凸显。医疗、金融、交通、零售、制造等众多行业的用户,都希望借助AI快速做出决策。这就要求AI推理一方面要能够在极短的时间内处理数据并生成结果,而另一方面,还要通过持续优化,在提升整体效率的同时尽量降低成本。

虽然AI训练和推理都讲究一个“快”字,但还是应该区别不同的应用场景和具体需求。AMD是行业内唯一同时拥有高性能GPU、CPU和FPGA平台性解决方案的厂商,再加上其ROCm开发平台日趋成熟,因此在AI训练+AI推理的整个生命周期中能够做到游刃有余,信手拈来。

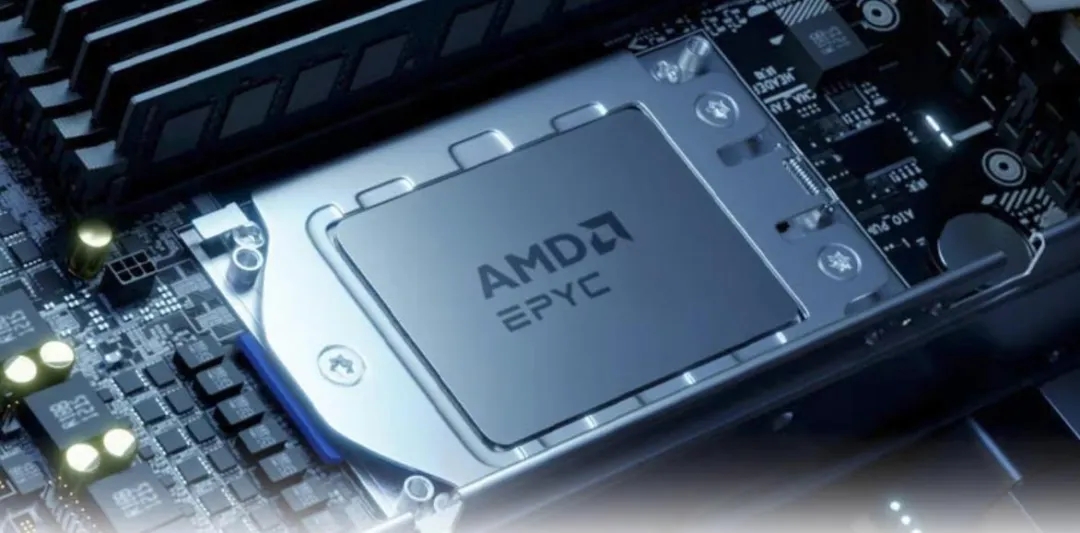

面向AI推理,AMD提供了一个非常经济的解决方案,就是搭载第四代AMD EPYC处理器的现有服务器,它可用于加速一系列数据中心和边缘应用。

第四代AMD

EPYC拼的都是硬实力

AI推理对于算力或者说具体到CPU,到底提出了哪些挑战?

第一,当然是满足高并发处理和低延迟的需求。AI推理需要处理大量并发任务,这就要求CPU具有强大的高并发处理能力,可以同时执行多个推理任务;尤其是对于实时应用来说,如自动驾驶、实时翻译等,CPU还要快速响应请求,最小化处理延迟。

第二,追求更高的能效比。由于AI模型的复杂度逐步增加,对算力的需求也会随之增加,在保证高性能的同时,还要不断降低能耗,这是CPU要突破的瓶颈。

第三,内存带宽和容量要充足。AI推理任务通常需要大量的内存带宽来处理海量数据,一些复杂的模型也需要较大的内存容量来存储模型参数和中间计算结果。

第四,成本效益不容忽视。随着AI逐步向各个行业领域渗透,保证性能的同时降低成本,使得AI推理更加经济高效是一个现实的挑战。

为了更好地应对上述挑战,从厂商的角度正在不断优化CPU的架构,通过采用更先进的制程技术、增加核心数量、提高内存带宽等手段,持续提升能效比,同时结合软件层面的优化,提高AI推理的整体性能。

AMD在AI推理方面的优势主要体现在,它拥有高性能、低功耗的芯片设计,以EPYC CPU为代表的先进的解决方案,能够很好地满足用户的定制计算需求,而开源策略以及对深度学习框架良好的兼容性等,更是锦上添花,使得AMD EPYC 平台成为AI推理任务的首选。

实际上,无论是在核心还是在边缘,使用搭载AMD EPYC处理器的服务器进行AI推理都是一个简单经济的选择。尤其是第四代 AMD EPYC处理器在加速推理操作方面取得了巨大进步。

那么,就让我们抽丝剥茧,看看第四代AMD EPYC处理器在执行AI推理任务时,究竟有哪些与众不同之处:采用Zen 4核心,与上一代处理器相比,核心架构的优化使得每个时钟周期的指令总数增加约14%;拥有更多核心数,Bergamo 搭载820亿个晶体管,最高支持128个Zen 4c核心,并且兼容x86 ISA指令,能够更好地满足高性能的云端需求;支持AVX-512指令扩展,AVX-512采用双周期、高效的256位流水线,有助于保持比AVX-2更高的频率,而VNNI组件可显著提高各种数据类型的AI推理性能;内存更快、通道数更多,借助DDR 5内存,再加上新增50%的内存通道(共12个),其内存吞吐量是上一代产品的2.25倍;更快的I/O,采用PCIe Gen 5 I/O,使得AMD EPYC处理器的I/O吞吐量在上一代的基础上翻了一番,实现了更快的数据获取,进而提升了AI推理的性能。

上述硬件配置与性能指标,说明了第四代AMD EPYC处理器具备了在AI推理方面大显身手的基本能力,但在实际测试和应用中,第四代AMD EPYC是否真如标称值那样敢打善战呢?

一些第三方机构和媒体对第四代AMD EPYC处理器进行了全方位测试。结果证明,第四代AMD EPYC处理器与上一代产品相比,在计算机视觉、自然语言处理和推荐引擎等方面确实有了显著提升。

《微型计算机》评测室对第四代AMD EPYC处理器的几款代表性产品,包括AMD EPYC 9654、EPYC 9554、EPYC 9374F进行了详细测试。例如,在通用计算型的产品中,AMD EPYC 9654以高性能闻名,广泛适用于数据库、虚拟化、人工智能/机器学习、高性能计算等场景。它的最大优势是拥有多达96核心,并且支持组建双路系统,为用户构建设192核心、384线程多核心的超多核心计算系统创造了条件,尤其是对那些亟需多线程运算性能的渲染与模拟、科学仿真用户来说颇具吸引力。另外,Phoronix通过使用TensorFlow 2.10和BF16数据类型运行Res-Net-50模型,测试了AMD EPYC 9654处理器所支持的 AVX-512指令对性能的影响。在开启AVX-512时,性能提高1.73倍,而且对时钟频率的影响很小,每瓦每秒处理的图像数几乎翻倍。

与其他第四代EPYC处理器不同的是,AMD EPYC 9374F处理器多了一个“F”,凸显了它拥有更高的单核心基频和最高加速频率,其基准频率为3.85GHz,单核心最高加速频率可达4.3GHz,全核心加速频率也达到了4.1GHz。这表明该处理器非常适合进行3D建模,以及像AEC(建筑、工程、施工)可视化等依赖处理器频率的各类应用。它拥有32核心、64线程配置,所以渲染、科学运算之类的工作也不在话下。

软件优化 锦上添花

实际上,硬件与软件如同人的左右手,只有协同工作,才能最大程度地发挥其优势。第四代AMD EPYC处理器的硬件设计固然优秀,但如果没有软件的优化,其价值的释放估计也会打一些折扣。

AMD一直是“两条腿”走路,始终确保其产品在主流深度学习框架上经过全面测试和认证,并提供高性能、稳定、易于部署的解决方案。这无疑为AI推理任务提供了强大的支持,确保了在各种应用场景中的兼容性和高效性。另外,AMD通过开放其关键技术,如ROCm软件堆栈,强化合作与创新,使得客户可以自主选择技术路径,而不是被限制在封闭系统中,从而让AI的潜能得以充分释放。

通过统一推理前端,用户可以选择想要部署的深度学习模型,并在所选的框架上执行推理,包括PyTorch、TensorFlow和ONNX Runtime。AMD所做的最重要的优化就是ZenDNN库,它可以加速AMD EPYC处理器上的深度学习推理工作负载。它深入软件堆栈,使用针对AMD EPYC处理器调优的等效运算符替换基本的AI原语。通过在原语级别进行优化,ZenDNN有助于跨不同应用程序类型加速各种模型。无论使用计算机视觉模型来识别产品缺陷,还是使用自然语言应用来响应客户的提示,或者使用引擎来主动指导维护,ZenDNN都有助于加速各种推理类工作负载。除了优化的原语之外,ZenDNN还包括重新组织和重组模型的图形和框架优化,可以更有效地使用计算和内存资源。

AI无限 计算无限

未来AI推理市场将呈现快速发展态势。Global Info Research调研显示,2023-2029年,全球AI推理服务器市场整体收入的年复合增长率将达到18.0%。AI推理正“飞入寻常百姓家”,它要求CPU能够更好地实现性能、能效、成本之间的平衡,并为用户带来更高的效率和更多的效益。

在AI推理方面,AMD的表现无疑是出色的,它采用统一的推理模型,便于在高性能GPU硬件上进行训练,然后在搭载AMD EPYC处理器的服务器上通过推理将模型无缝转移到生产中。AMD的核心策略是在整个Al生命周期中提供软硬件的全面支持,帮助用户在核心、云和边缘进行推理,同时提供优化模型与软件栈,充分发挥AMD作为AI底座的强大能力。

大量测试以及成功实践表明,第四代AMD EPYC 处理器能够很好地胜任AI理推任务。AMD在相关领域的投资和创新也会持续下去。在近日举行的Computex 2024上,AMD预览了将于2024年下半年发布的、具有领先性能和效率的第五代 AMD EPYC服务器处理器。AI的快速普及正在推动行业对AMD高性能计算平台的需求持续增长。

内容转载自:云数智观察